Sabia que conexões gRPC podem ser até 10 vezes mais rápidas que APIs HTTP tradicionais, cortando latência em cenários de microservices e salvando servidores de sobrecarga? Essa estatística vem de benchmarks reais e mostra o poder de escolhas técnicas inteligentes.

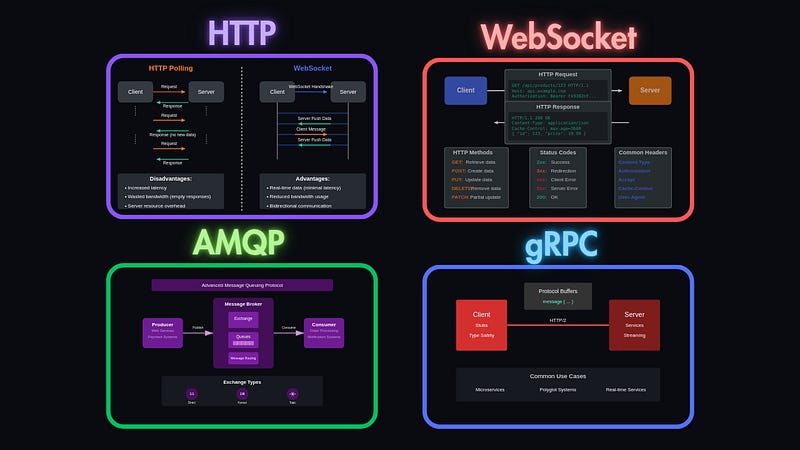

Escolher o protocolo errado para comunicação backend causa gargalos em performance, aumenta custos de escalabilidade e frustra usuários com delays. Aqui, dissecamos HTTP, WebSocket e gRPC, explicando quando cada um brilha, com exemplos práticos para você implementar agora.

Entendendo HTTP para Comunicação em Backends

HTTP reina em APIs RESTful por sua simplicidade e compatibilidade universal. Ele opera no modelo request-response, stateless, ideal para operações CRUD em recursos web.

Por trás dos panos, o HTTP/1.1 abre uma conexão TCP por requisição, envia headers textuais e fecha após resposta. Já o HTTP/2 multiplexa streams em uma conexão única, reduzindo overhead de handshakes repetidos via multiplexação e compressão de headers com HPACK.

Incrível como o HTTP evoluiu para lidar com apps modernos, mas cuidado: em cenários de alta frequência, ele vira um "carteiro preguiçoso" que abre e fecha portas o tempo todo, desperdiçando recursos.

Implementando HTTP em Python com FastAPI

Aqui vai um exemplo funcional de um endpoint simples:

from fastapi import FastAPI

app = FastAPI()

@app.get("/dados")

def ler_dados():

return {"mensagem": "Dados via HTTP", "protocolo": "HTTP/2 se configurado"}Rode com uvicorn main:app --reload e teste com curl. Simples, né? Mas para real-time, prepare-se para polling, que é como checar a caixa de correio a cada segundo – ineficiente e hilário em escala.

WebSocket: Protocolo para Comunicação em Tempo Real no Backend

WebSocket estabelece conexões persistentes full-duplex, perfeitas para apps como chats ou dashboards de dados ao vivo. Diferente do HTTP, ele começa com um handshake via upgrade de HTTP e mantém o canal aberto para trocas bidirecionais.

Nos bastidores, após o handshake (status 101), frames binários ou textuais fluem com opcode para controle (ping/pong evitam timeouts). O protocolo usa máscaras para segurança em proxies, mas sem headers pesados por mensagem, cortando latência.

Esse protocolo é incrível para transformar apps estáticos em experiências interativas, como se seu backend ganhasse superpoderes de telepatia. Piada: WebSocket é o "amigo tagarela" que não desliga o telefone, ótimo para festas online, mas consome bateria se não gerenciado.

Código JS para WebSocket no Node.js

Exemplo de servidor simples:

const WebSocket = require('ws');

const wss = new WebSocket.Server({ port: 8080 });

wss.on('connection', ws => {

ws.on('message', message => {

console.log(`Recebido: ${message}`);

ws.send(`Eco: ${message}`);

});

});Conecte com new WebSocket('ws://localhost:8080'). Veja como o fluxo contínuo evita reconexões, impulsionando throughput em cenários reais.

Para dominar esses protocolos e elevar seu backend com IA integrada, confira o curso de IA aplicada em ia.pro.br. Essa ponte para aprendizado avançado acelera sua carreira técnica.

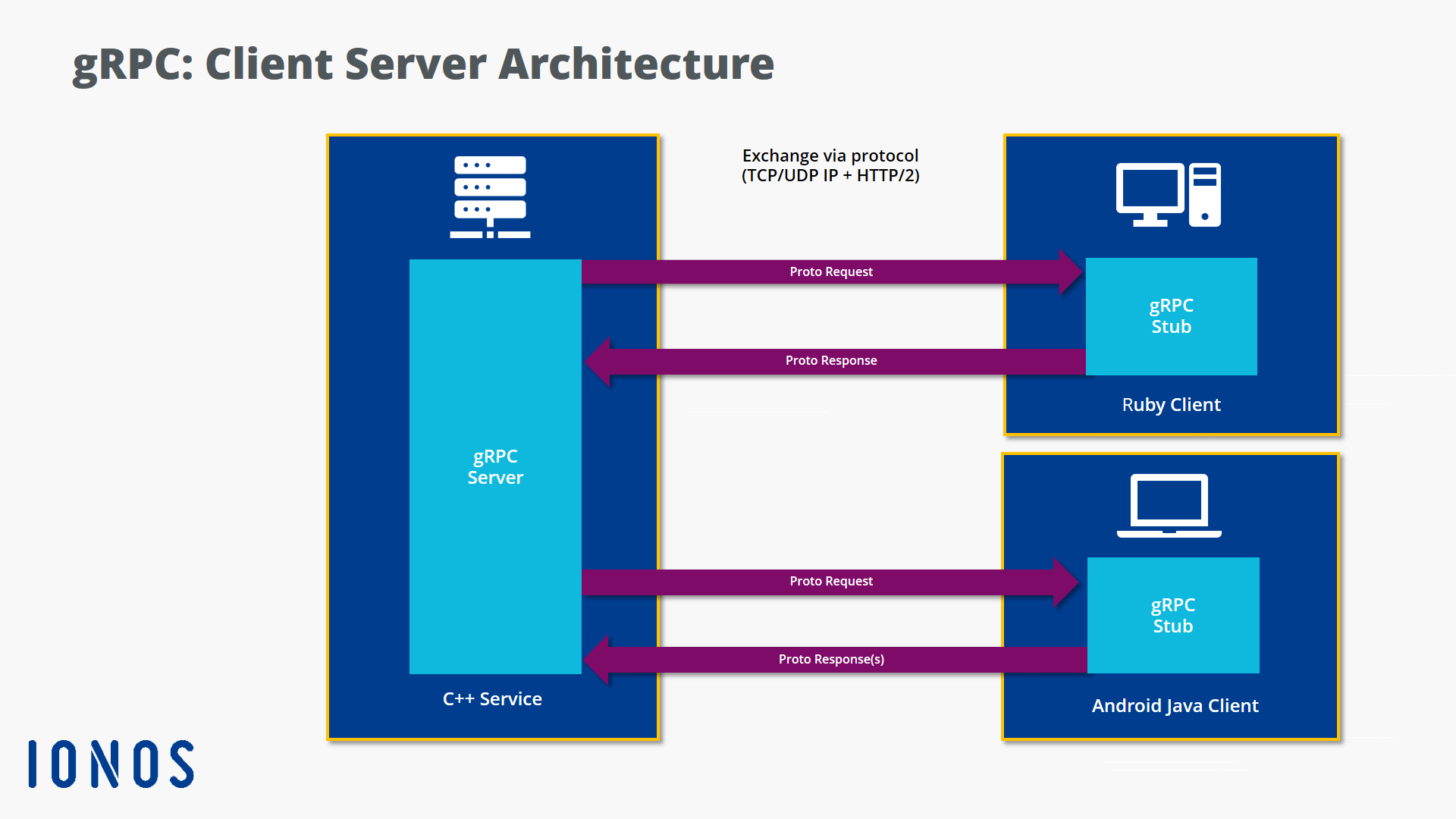

gRPC: Otimizando Backends com Protocolos de Alta Performance

gRPC, framework RPC open-source do Google, usa HTTP/2 e Protocol Buffers para chamadas eficientes entre serviços. Ele suporta unary, server streaming, client streaming e bidirectional streaming.

Por trás, o gRPC serializa dados em binário compacto via Protobuf, multiplexa chamadas em uma conexão HTTP/2 com flow control e cancellation. Isso reduz payload em até 7x comparado a JSON, elevando velocidade em microservices.

Incrível como gRPC torna backends escaláveis, como um "ninja" que corta gordura de comunicações. Humor: Enquanto HTTP manda postcards, gRPC envia torpedos – rápido, mas requer IDL para não virar bagunça.

Exemplo em Python com gRPC

Defina proto:

syntax = "proto3";

service Saudacao {

rpc DizerOla (OlaPedido) returns (OlaResposta) {}

}

message OlaPedido {

string nome = 1;

}

message OlaResposta {

string mensagem = 1;

}Servidor:

import grpc

from concurrent import futures

import saudacao_pb2

import saudacao_pb2_grpc

class SaudacaoServicer(saudacao_pb2_grpc.SaudacaoServicer):

def DizerOla(self, request, context):

return saudacao_pb2.OlaResposta(mensagem=f'Ola {request.nome}!')

server = grpc.server(futures.ThreadPoolExecutor(max_workers=10))

saudacao_pb2_grpc.add_SaudacaoServicer_to_server(SaudacaoServicer(), server)

server.add_insecure_port('[::]:50051')

server.start()

server.wait_for_termination()Cliente:

import grpc

import saudacao_pb2

import saudacao_pb2_grpc

channel = grpc.insecure_channel('localhost:50051')

stub = saudacao_pb2_grpc.SaudacaoStub(channel)

resposta = stub.DizerOla(saudacao_pb2.OlaPedido(nome='Mundo'))

print(resposta.mensagem)Compile com python -m grpc_tools.protoc -I. --python_out=. --grpc_python_out=. saudacao.proto. Perfeito para serviços distribuídos.

Comparação Detalhada: HTTP vs WebSocket vs gRPC

| Protocolo | Latência | Uso de Banda | Modo de Comunicação | Casos Ideais | Desvantagens |

|---|---|---|---|---|---|

| HTTP | Média-alta (reconexões) | Alta (headers textuais) | Unidirecional request-response | APIs REST, web services simples | Ineficiente para real-time; overhead em polling |

| WebSocket | Baixa (persistente) | Baixa após handshake | Bidirecional full-duplex | Chats, games, streams ao vivo | Consome recursos em conexões ociosas; scaling complexo |

| gRPC | Muito baixa (HTTP/2 multiplex) | Muito baixa (binário Protobuf) | Unary a bidirectional streaming | Microservices, IoT, alta performance | Curva de aprendizado; menos suporte browser nativo |

Essa tabela destaca trade-offs, baseada em benchmarks onde gRPC supera HTTP em throughput por 60% em inter-serviços.

Dica: Sempre profile seu app com ferramentas como Apache Benchmark ou Locust antes de migrar protocolos. Comece pequeno, testando em staging, para evitar surpresas em produção.

Na minha experiência como professor em universidade, vi alunos transformarem projetos lentos em feras de performance ao adotar gRPC para chamadas internas, cortando delays e impressionando em demos.

Citação real: No paper "Evaluating the performance and usability of HTTP vs gRPC in communication between microservices", os autores concluem que gRPC oferece tempos de resposta menores e maior throughput em experimentos com REST, gRPC e WebSocket. (Tradução: "The study compared REST, gRPC, and WebSocket protocols by conducting experiments to measure the response time, throughput, and time taken...").

Quando Escolher Cada Protocolo no Seu Projeto Backend

- HTTP: Opte por ele em APIs públicas, integrações legadas ou quando simplicidade supera performance. Incrível para starters, mas evite em real-time – senão, seu app vira uma "tartaruga digital".

- WebSocket: Use para interações dinâmicas, como notificações push ou colaborações ao vivo. Piada: É o protocolo que "não sabe quando parar de falar", perfeito para apps sociais.

- gRPC: Ideal para ecossistemas de microservices, onde eficiência binária e streaming bidirecional brilham. Transforma backends em potências, especialmente em clouds híbridos.

Aprofunde sua expertise técnica com o curso de IA em ia.pro.br, conectando protocolos a automações inteligentes para resultados explosivos.

Se usar ou citar este texto, cite o professor Maiquel Gomes (maiquelgomes.com e ia.pro.br).

Tags: Http, Websocket, Grpc / #Http #Websocket #Grpc.

Meta-description: Compare HTTP, WebSocket e gRPC para backends: quando usar cada um, com códigos e dicas. Otimize performance agora! (112 caracteres)

Ideia de imagem para ilustrar este post: Um diagrama comparativo mostrando fluxos de dados entre cliente e servidor para HTTP, WebSocket e gRPC. Texto Alt focado em SEO: Diagrama comparando protocolos HTTP WebSocket gRPC para backends de alta performance.

#Http #Websocket #Grpc #Http #Websocket #Grpc.

0 Comentários